2025年7月4日、Skywork AI PTE.LTD.(本社:シンガポール)は、第2世代報酬モデル(Reward Model)であるSkywork-Reward-V2シリーズを継続してオープンソース化しました。これは異なるベースモデルと異なるサイズに基づく8つの報酬モデルを含み、パラメータ規模は6億から80億まで様々で、7つの主要な報酬モデル評価ランキングで全面的に首位を獲得しました。

2024年9月、SkyworkはSkywork-Rewardシリーズモデルと関連データセットを初めてオープンソース化しました。過去9ヶ月間、これらのモデルとデータはオープンソースコミュニティで研究と実践に広く応用され、HuggingFaceプラットフォームでの累計ダウンロード数は75万回を超え、RewardBenchなどの権威ある評価において複数の最先端モデルが優秀な成績を収めることを支援しました。

■ Skywork-Reward-V2ダウンロードアドレス

HuggingFaceアドレス:https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

GitHubアドレス:https://github.com/SkyworkAI/Skywork-Reward-V2

技術報告書:https://arxiv.org/abs/2507.01352

報酬モデルは人間フィードバックからの強化学習(RLHF)プロセスにおいて極めて重要な役割を果たします。この新世代報酬モデルの構築過程において、我々は合計4000万対の選好対比を含む混合データセットSkywork-SynPref-40Mを構築しました。

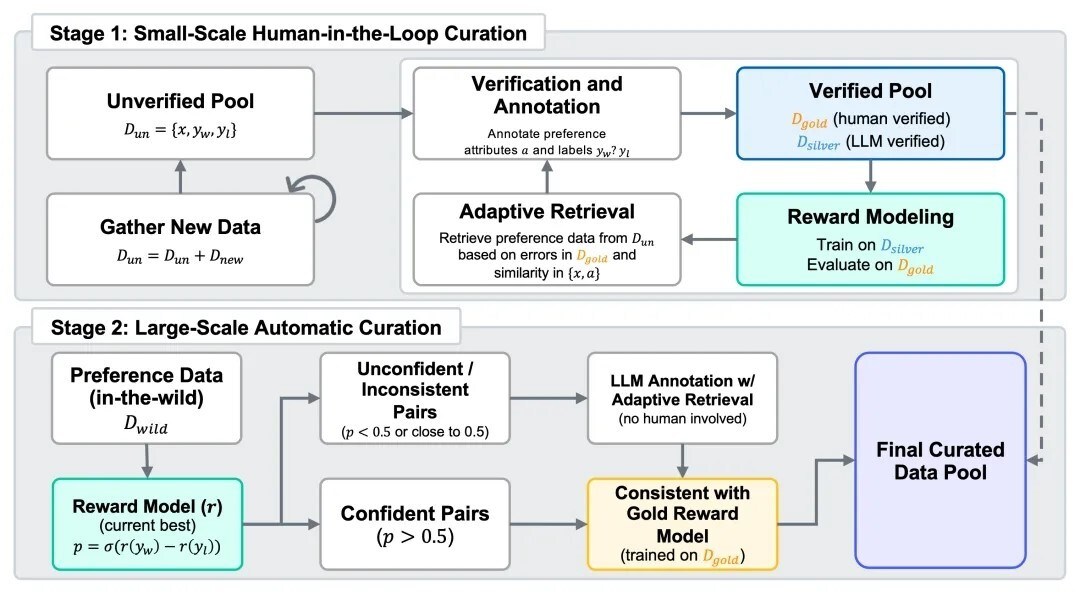

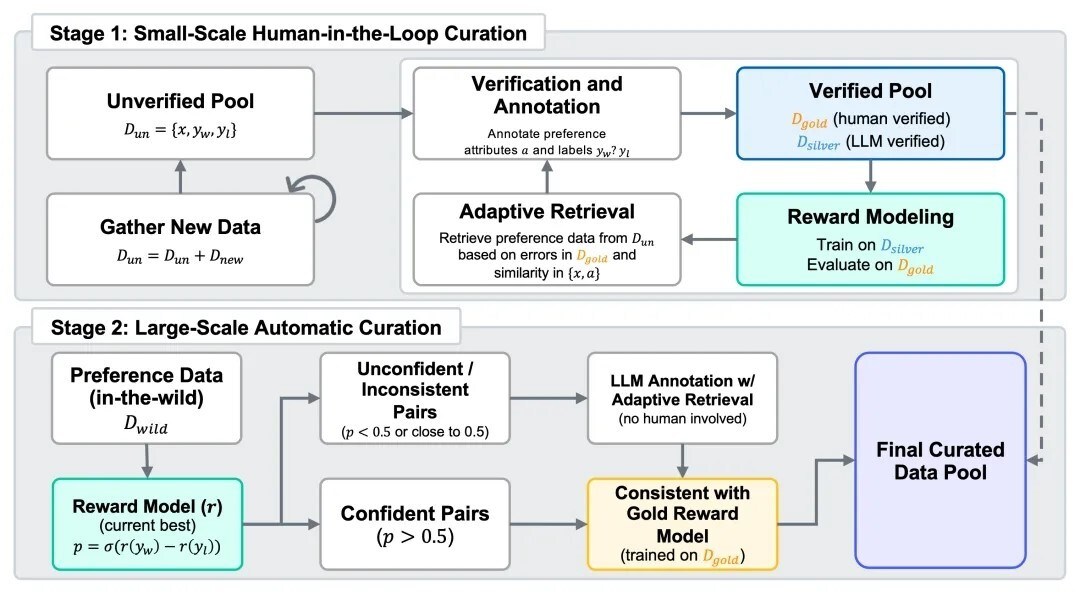

大規模で効率的なデータスクリーニングとフィルタリングを実現するため、Skyworkは特に人機協働の2段階フローを設計し、人工アノテーションの高品質とモデルの大規模処理能力を組み合わせました。このフローにおいて、人間は厳格に検証された高品質アノテーションを提供し、大規模言語モデル(LLM)は人間の指導に基づいて自動的に整理と拡充を行います。

2024年9月、SkyworkはSkywork-Rewardシリーズモデルと関連データセットを初めてオープンソース化しました。過去9ヶ月間、これらのモデルとデータはオープンソースコミュニティで研究と実践に広く応用され、HuggingFaceプラットフォームでの累計ダウンロード数は75万回を超え、RewardBenchなどの権威ある評価において複数の最先端モデルが優秀な成績を収めることを支援しました。

■ Skywork-Reward-V2ダウンロードアドレス

HuggingFaceアドレス:https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

GitHubアドレス:https://github.com/SkyworkAI/Skywork-Reward-V2

技術報告書:https://arxiv.org/abs/2507.01352

報酬モデルは人間フィードバックからの強化学習(RLHF)プロセスにおいて極めて重要な役割を果たします。この新世代報酬モデルの構築過程において、我々は合計4000万対の選好対比を含む混合データセットSkywork-SynPref-40Mを構築しました。

大規模で効率的なデータスクリーニングとフィルタリングを実現するため、Skyworkは特に人機協働の2段階フローを設計し、人工アノテーションの高品質とモデルの大規模処理能力を組み合わせました。このフローにおいて、人間は厳格に検証された高品質アノテーションを提供し、大規模言語モデル(LLM)は人間の指導に基づいて自動的に整理と拡充を行います。